Calibre et l'IA

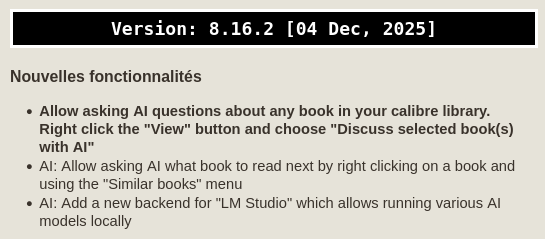

Il y a quelques jours, j'ai découvert via un pouet que le logiciel Calibre, un logiciel de gestion de livres électroniques, intégre depuis la version 8.16.2 du 4 décembre 2025 des nouvelles fonctionnalités liées à l'intelligence artificielle.

Nouvelles fonctionnalités

Allow asking AI questions about any book in your calibre library. Right click the "View" button and choose "Discuss selected book(s) with AI"

AI: Allow asking AI what book to read next by right clicking on a book and using the "Similar books" menu

AI: Add a new backend for "LM Studio" which allows running various AI models locally

Évidemment, il y a déjà un fork appelé clbre (puisque sans AI... les développeurs ont de l'humour). Et évidemment, ça m'a fait râler. Sous mon message, deux personnes m'ont demandé d'expliquer pourquoi ça me fait ronchonner. Et ces explications là, elles rentrent pas dans un message de 500 caractères. Donc j'ai promis de répondre dans un article de blog et nous y voilà.

Pour commencer concrètement, je voudrais revenir sur le tableau général de l'IA, ce que ça implique déjà aujourd'hui et ce que ça va impliquer demain. Enfin, forts de ces constats, il sera toujours temps de se demander s'il est pertinent (ou pas) d'intégrer des fonctionnalités de ce type dans un logiciel existant qui fonctionne et fait ce qu'on lui demande.

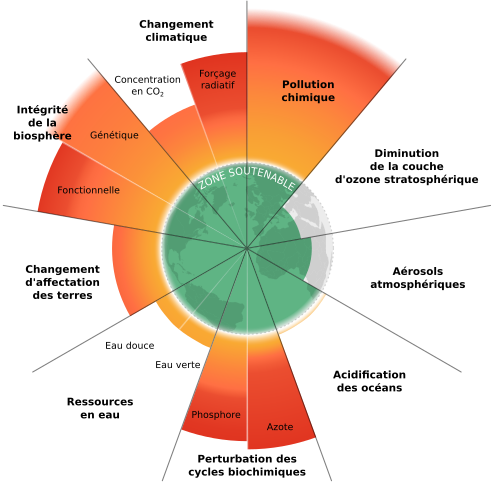

C'est parti? C'est parti! Je vous fait grâce de vous expliquer qu'une partie de l'humanité est en train de modifier de manière irréversible le climat et les écosystèmes et qu'on a dépassé depuis longtemps la plupart des limites planétaires, ces seuils qui permettent d'avoir des conditions de vie favorables pour l'humanité et le reste du monde vivant... Vous le savez de toute façon, non? Hein, vous le savez?

Dans ce contexte, il serait logique qu'on réfléchisse à l'organisation du monde, qu'on regarde comment on peut assurer un niveau de vie décent à tous les citoyens du monde. Apparemment, il faudrait ~30% des ressources et énergie utilisées annuellement pour y parvenir. Mais ce n'est pas vraiment le chemin que l'humanité semble prendre... Étonnant, pas vrai ? (Ça s'explique... Coucou le capitalisme. Mais ça mériterait un autre article.)

Ce qu'il se passe, c'est que l'arrivée de ChatGPT par OpenAI il y a un peu plus de trois ans a démarré une nouvelle course à la puissance de calcul et au gigantisme des datacenters. Un article du monde explique en détail «Comment l'IA dévore la planète». Je suis pas très motivé pour vous résumer l'article, vous irez le lire si ça vous intéresse. Mais pour faire bref : C'est la merde.

Qu'on parle de la consommation de métaux issus des terres rares, de l'augmentation de la consommation d'eau et d'énergie pour la fabrications des cartes graphiques et autres composants, de l'artificialisation des sols, de la consommation d'énergie pour faire tourner les centres de données... Tout est énorme. D'après le monde, la consommation d'énergie des datacenters pourrait tripler d'ici à 2030. (Oui oui, tout ça pendant qu'on responsabilise les individus et qu'on vous promeut sans gène les «petits pas» pour faire de l'écologie...) En Belgique, le gestionnaire du réseau électrique s'attend à ce que la consommation d'électricité des datacenters quintuple d'ici 2030.1

Mais si on fait abstraction de l'écologie (ce qui me semble stupide mais bon, c'est pour l'exercice hein...), c'est quoi le problème de l'intelligence artificielle et plus spécifiquement des LLM ?

Aujourd'hui, il y a plusieurs critiques à faire par rapport aux LLM. En voici quelques-unes (ce n'est pas exhaustif!) :

-

Les LLM ne sont pas fiables. Ils hallucinent, font des erreurs, inventent des chiffres, ... Il y a des exemples sur Wikipédia mais on en trouve partout.

-

Les LLM sont déjà utilisés pour désinformer. Le web est déjà innondés d'articles générés par LLM. Il suffit d'installer l'add-on «Alerte sur les sites GenAI» de Sébastien Gavois et géré par Next.ink. Ça peut paraitre anecdotique à côté de reste, mais ça rend la recherche d'informations vraiment plus compliquée et ça fait disparaitre les vraies informations sous des milliers de sites inutiles. L'Europe travaille là dessus et propose des bonnes pratiques pour le marquage et l'étiquetage des contenus générés par l'IA et indique que ces règles de transparence deviendront applicables dès le 2 août 2026. J'ai bien peur que ça ne suffise pas à endiguer le torrent de contenus (texte, images, vidéos) qui est déjà en train de nous submerger mais c'est mieux que rien, j'imagine. Dans un édito de février 2025 sur Next.ink, l'auteur expliquait comment ils ont découvert plus de 1000 sites et il écrivait: «Le problème, c'est que ces contenus générés par IA ne s'embarrassent souvent ni de véracité, ni de légalité.». Aujourd'hui, près de 10 000 sites ont été découverts. (TV5 Monde a d'ailleurs fait un reportage à ce sujet.)

-

L'utilisation des LLM augmente les ressources utilisées par les terminaux. J'ai trouvé un article qui compare ChatGPT et DeepSeek. Augmentation de la consommation d'énergie (donc la batterie se vide), augmentation du trafic réseau, augmentation de la charge CPU... Je n'ai pas encore trouvé de chiffres dans le cas où c'est un LLM qui tourne directement sur la machine mais j'ai du mal à penser que ça va améliorer quoi que ce soit (à part éventuellemet la vie privée, peut-être?). Le problème? Ça va contribuer à rendre obsolète plein de terminaux fonctionnels alors que l'impact carbone du numérique provient pour une grande partie de la fabrication des terminaux. «(...) l'allongement de la durée de vie de nos terminaux constitue un véritable défi.», qu'on nous dit.

-

L'entrainement d'un LLM, ça a un coût important (en puissance de calcul, en énergie dépensées, coût économique, etc.) Et même si le LLM est ensuite utilisé en local, ça n'empêche pas qu'il a du être entrainé au départ.

-

Les IA pillent nos données. Lors de l'entrainement d'un LLM, on utilise un corpus énorme de données. Certains modèles sont déjà entrainés avec des billions de jetons.2 Et... Elles viennent d'où ces données? Et bien les entreprises qui entrainent des IA ne sont pas très bavardes à ce sujet mais on sait qu'ils récoltent tout ce qu'ils peuvent. Sites d'informations, blogs personnels, réseaux sociaux, livres téléchargés illégalement sur Z-Library et LibGen et même des films pornographiques d'après certaines sources... Tout ça pour que Grok puisse déshabiller n'importe qui à partir d'une photo? Ce qui est sûr, c'est que l'IA se nourrit du travail de millions de créateurs dans le monde, sans l'approbation des créateurs. Miyazaki est un bon exemple. Oh, j'oubliais... Ils collectent aussi les données de santé.🤦 Hasard du calendrier, on commémore aujourd'hui le décès d'Aaron Swartz qui s'est suicidé un mois avant un procès où on lui repprochait d'avoir téléchargé 4,8 millions d'articles scientifiques dans le but de les rendre publiques gratuitement. Il était menacé de 35 ans de prison.

-

À cause de l'IA (et des commerciaux qui arrivent à convaincre les patrons que l'IA peut remplacer des travailleurs humains), des milliers de gens vont perdre leur emploi. D'autres vont voir leur travail se transformer en "micro-managers d'IA", pour vérifier que l'IA a fait les choses correctement. Ça promet du fun et du sens dans le travail... Et en parallèle, les dirigeants d'un peu partout dans le monde disent qu'il y a trop de gens au chômage. Mais ils applaudissent les investissements des géants du numérique qui "créent des emplois". Ah ah. Ça pourrait presque être drôle. Moi je suis pour qu'on travaille moins et qu'on partage équitablement les revenus du travail. Mais je suis prêt à parier que c'est pas ce qu'il va se passer (coucou capitalisme!).

Donc... Résumons. Les LLM, ça bousille la planète. C'est en train de rendre le web inutilisable. Ça désinforme massivement. Ça pille massivement tout ce qui a été produit par l'humanité. Et tout ça pour quels usages utiles ? Remplir des rapports chiants que personne ne lira et qui n'ont aucun intérêt ? Résumer des mails longs générés par IA pour répondre ensuite par IA ? Proposer une aide inutile et inadaptée sur les sites commerciaux ? Générer des cartes de bons vœux ? Tricher aux examens ? Innonder le web de Deepfakes pour influencer l'opinion des gens ? L'extrême droite adore l'IA, ce n'est pas pour rien...

Ok, je suis énervé maintenant.

Pour revenir à Calibre et conclure cet article, je voudrais proposer quelque chose. Avant d'inclure une fonctionnalité basée sur l'IA dans un logiciel, posez-vous une seule question : «Est-ce que ça a du sens ?» Est-ce qu'on a besoin de causer de ses bouquins avec une IA ? Si vous avez besoin de parler de ce que vous lisez, rejoignez un club de lecture, organisez un arpentage de «L'envers de la tech» de Mathilde Saliou, prêtez-vous des livres ou venez poueter sous le tag #vendrediLecture sur le fediverse.

Oh, juste un dernier détail. Je ne doute pas qu'il doit y avoir des utilisations intelligentes de l'IA dans certains domaines. Mais est-ce que ça justifie qu'on balance de l'essence sur la maison qui brûle ?

Aller plus loin :

-

Donc Elia s'attend à ce que les datacenters consomment jusqu'à 16 TWh en Belgique. Alors qu'on doit baisser notre consommation d'énergie et la quantité de dioxyde et carbone et des autres gaz à effet de serre et alors qu'il n'y a pas longtemps on nous parlait beaucoup de délestage et d'inquiétudes par rapport à une pénurie d'électricité (voir ce rapport d'Ores.) ↩

-

Un "billion", en français, ça correspond à mille milliards. 10^12. 1 000 000 000 000. (En anglais, un billion ne vaut "que" mille millions.) ↩